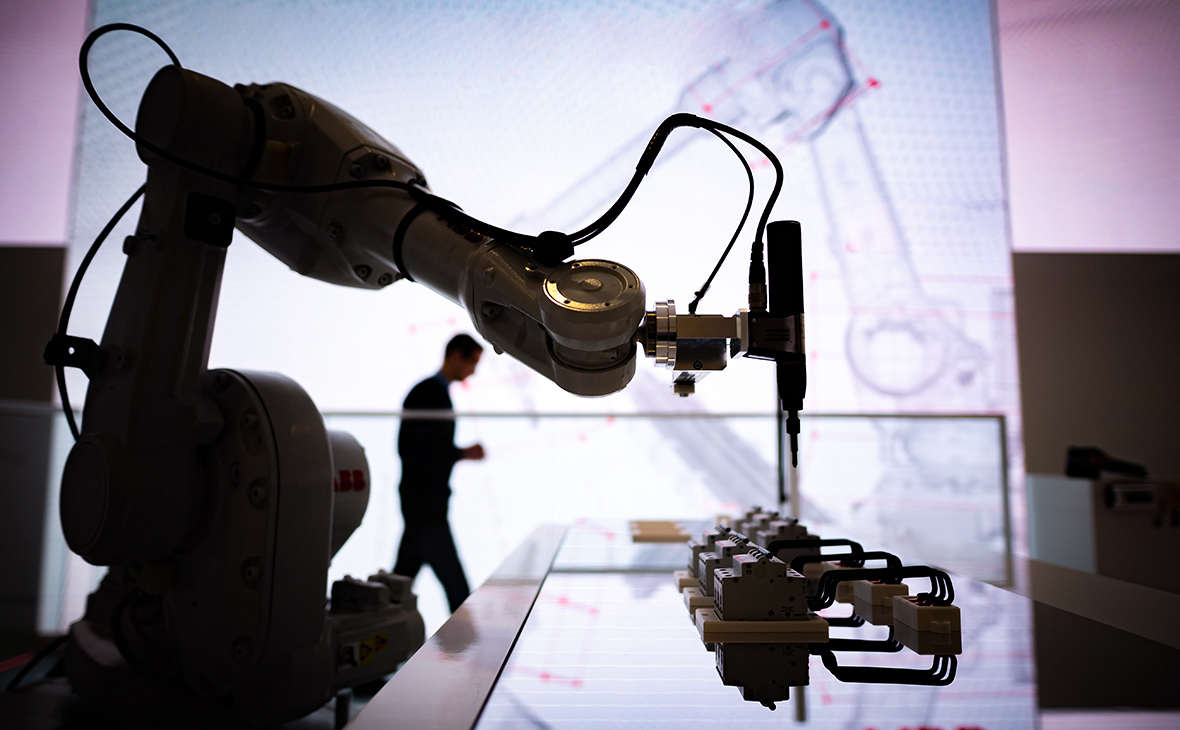

Использование искусственного интеллекта на объектах критической инфраструктуры очень рискованно из-за возникновения потенциально новых угроз, поэтому в России будут разрабатывать системы контроля за его внедрение, об этом ТАСС сообщил академик РАН Арутюн Аветисян, передает телеканал «Якутия 24».

«Для борьбы с такими угрозами нужны специальные инструменты. А их пока не существует. Чтобы решить эту проблему, как раз и создан наш Исследовательский центр доверенного ИИ. Без соответствующих доверенных технологий внедрение ИИ будет ограничено. Это касается и России, и всего мира в целом», — отметил он.

Академик добавил, что технологии ИИ связаны не с алгоритмическим описанием в виде кода, а с решением задач по аналогии.

«Есть данные, мы обучаем модель, она пытается вывести какие-то закономерности из этих данных, а потом пытается найти эти закономерности в новых данных, которые она до этого не видела. Например, можно немного поменять входные данные, и человеку будет казаться, что это одно и то же, а для автоматической системы это будет другое. Если система, внедренная в беспилотный автомобиль, увидит знак, который загрязнен или на него нанесены какие-то метки, то для автомобиля это может быть уже другой знак или отсутствие знака, что, очевидно, может привести к аварии», — пояснил ученый.

Исследовательский центр доверенного искусственного интеллекта работает с 2021 года на базе ИСП РАН. Специалисты центра создали так называемые доверенные версии популярных фреймворков машинного обучения TensorFlow и PyTorch. Центр активно развивает разработку технологий доверенного ИИ.